OpenAI 周一发布的新数据显示,ChatGPT 存在严峻的用户心理健康相关对话问题——每周超8亿活跃用户中,0.15%的对话包含“潜在自杀计划或意图的明确指标”,换算后每周超百万人通过ChatGPT谈论自杀。此外,同等比例用户对ChatGPT表现出“高情感依恋”,数十万人的对话中存在精神病或躁狂迹象。针对这一问题,OpenAI已升级GPT-5模型的响应能力,并推出儿童保护、安全评估等配套措施,但仍面临诉讼与监管压力。

核心数据:问题覆盖范围广,部分情况难测量

尽管OpenAI称这类心理健康相关对话“极其罕见”,但数据仍揭示出问题的广泛性,且部分情况因特殊性难以精准统计:

- 自杀相关对话:每周超百万用户(活跃用户的0.15%)的对话中,有明确的潜在自杀计划或意图指标,这一规模与ChatGPT超8亿的周活跃用户基数直接相关。

- 情感与精神健康信号:0.15%用户对ChatGPT表现出“高情感依恋”,同时每周有数十万人的对话中,存在精神病或躁狂的迹象。

- 测量难度:由于这类对话场景特殊、表述多样,OpenAI坦言“难以精确测量”,当前数据为估算结果,实际情况可能存在偏差。

应对措施:升级模型、加评估、护儿童

为缓解心理健康相关对话的风险,OpenAI从“模型响应”“安全评估”“儿童保护”三个维度推进改进:

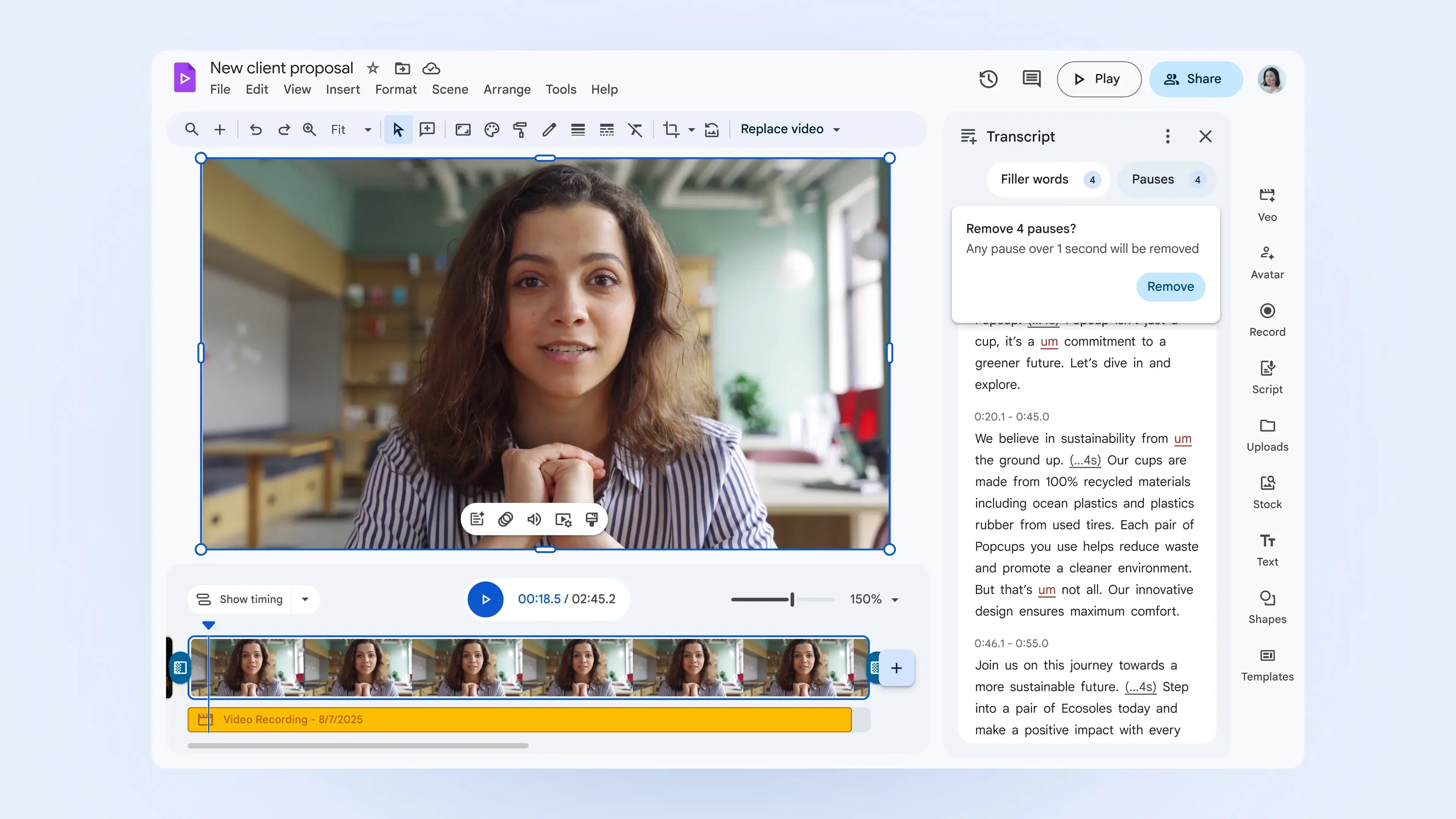

1. GPT-5模型:响应安全性显著提升

- 理想响应率提高:针对心理健康问题,最新版GPT-5的“理想响应”比例比前一版本高约65%;其中在自杀相关对话的响应评估中,符合公司期望行为的比例达91%,远超旧版GPT-5的77%。

- 长对话保障增强:此前OpenAI曾承认“模型保障措施在长对话中效果较差”,而新版GPT-5在长时间互动中,能更好地遵守安全规则,减少不当响应。

2. 新增安全评估:覆盖情感依赖与紧急情况

- 在AI模型的基准安全测试中,新增“情感依赖”“非自杀心理健康紧急情况”两类评估维度,通过更全面的测试,提前发现模型在这类场景下的响应漏洞。

3. 儿童保护:自动检测+严格限制

- 为使用ChatGPT的儿童父母提供更多控制工具,同时开发“年龄预测系统”,通过技术手段自动识别儿童用户。

- 对检测出的儿童用户,施加更严格的安全保障措施,减少其接触风险内容的可能。

外部压力与现存问题:诉讼未消,旧模型仍在使用

尽管OpenAI已采取多项措施,但围绕ChatGPT的心理健康相关争议尚未平息,且存在明显的待解问题:

1. 诉讼与监管压力大

- 目前OpenAI面临一名16岁男孩父母的起诉,该男孩在自杀前几周曾向ChatGPT倾诉自杀念头,家属认为平台未履行安全保障义务。

- 加利福尼亚、特拉华两州的检察长也已提出警告,要求OpenAI加强对未成年人的保护,甚至可能影响公司计划中的重组进程。

2. 旧模型安全风险未消除

- OpenAI仍为数百万付费订阅用户提供较旧的AI模型(如GPT-4o),这类模型的安全性低于新版GPT-5,存在响应不当的风险。

- 即便新版GPT-5,OpenAI也承认其响应中仍有“不理想”的部分,尚未实现100%安全覆盖。

3. 矛盾决策引发争议

- 此前OpenAI CEO萨姆·奥特曼(Sam Altman)曾表示“已缓解ChatGPT中的严重心理健康问题”,但未提供细节;此次数据披露虽印证改进方向,却也暴露问题规模远超公众预期。

- 更具争议的是,Altman同时宣布“将放松部分限制,允许成年用户与ChatGPT进行色情对话”,这一决策与“强化心理健康保护”的目标存在冲突,引发对平台安全优先级的质疑。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...