NexaSDK 是由 Nexa AI 团队推出的本地 AI 推理开发工具包,目标是让任何 AI 模型都能在任何本地设备上高效运行——无论你是开发者、系统集成商,还是边缘计算或车载场景的工程团队。

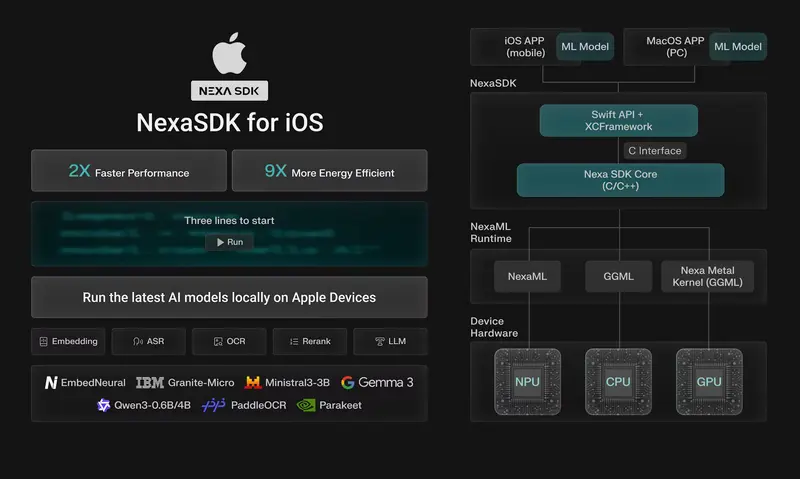

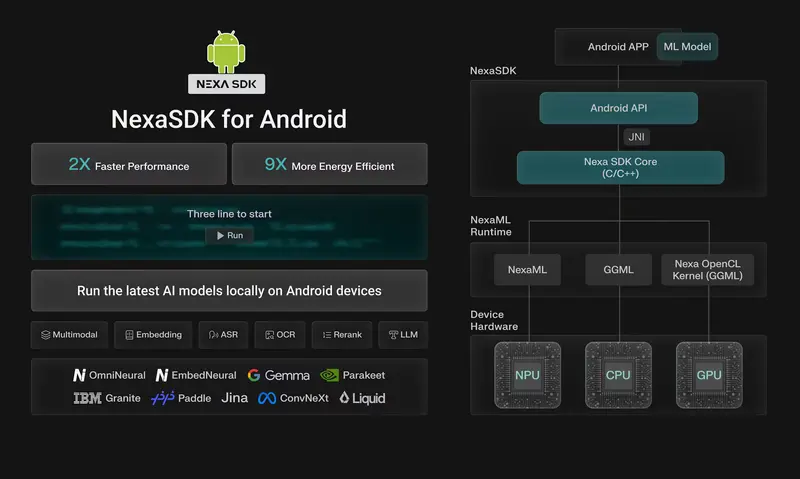

其核心是 NexaML 引擎,一个从零自研的推理框架,专为多模态、多硬件环境设计。不同于简单封装第三方库的方案,NexaML 直接构建于硬件抽象层之上,实现对最新模型的 Day-0 支持 与 极致性能优化。

核心能力

- 全模型支持:大语言模型(LLM)、视觉语言模型(VLM)、计算机视觉、嵌入(Embedding)、重排序(Reranker)、语音识别(ASR)、文本转语音(TTS)等。

- 全格式兼容:原生支持 GGUF、MLX 与 Nexa 自有的 .nexa 格式,是目前唯一完整兼容 GGUF 多模态扩展的推理框架。

- 全硬件覆盖:

- NPU:Qualcomm Hexagon、Apple Neural Engine(ANE)、Intel NPU、AMD NPU

- GPU:Apple Metal、AMD RDNA、集成/独显通用支持

- CPU:x86/ARM,支持多线程与量化加速

- 全平台部署:

- 桌面:Windows、macOS、Linux(含 Docker 镜像)

- 移动端:Android(Java/Kotlin 与 Python SDK)、iOS

- 嵌入式场景:车载(如 Qualcomm SA8295P)、IoT 设备

与其他工具的关键差异

| 功能特性 | NexaSDK | Ollama | llama.cpp | LM Studio |

|---|

| NPU 原生支持 | ✅(优先优化) | ⚠️(部分实验性) | ⚠️(依赖后端) | ❌ |

| Android/iOS SDK | ✅(NPU/GPU/CPU) | ⚠️(仅桌面) | ⚠️(有限) | ❌ |

| Linux(含 Docker) | ✅ | ✅ | ✅ | ❌ |

| 全格式支持(GGUF/MLX/.nexa) | ✅(底层控制) | ❌ | ⚠️(仅 GGUF) | ❌ |

| 完整多模态(图/音/文) | ✅ | ⚠️(文本为主) | ⚠️ | ⚠️ |

| 跨平台(桌面/移动端/车载/IoT) | ✅ | ⚠️ | ⚠️ | ⚠️ |

| 一行代码启动 | ✅ | ✅ | ⚠️(需编译) | ✅ |

| OpenAI 兼容 API + Function Calling | ✅ | ✅ | ✅(via server) | ✅ |

✅:完整支持 | ⚠️:有限或实验性支持 | ❌:不支持

最新进展(2025 年)

- 高通官方认可:NexaSDK for Android 被 高通博客称为 “将端侧 AI 引入 骁龙智能手机的简易方案”,NexaML 引擎则被誉为 “革新端侧 AI 推理”。

- 车载 AI 突破:发布 AutoNeural-VL-1.5B,专为车载 NPU 优化,在 高通SA8295P 平台实现:

- 14 倍时延降低

- 3 倍解码加速

- 4 倍上下文长度扩展

现已扩展支持 Qualcomm X Elite 笔记本平台。

- Day-0 模型支持:

- Qwen3-VL-4B/8B(GGUF/MLX/.nexa,NPU/GPU/CPU)——Qwen 官方联合发布,NexaSDK 为唯一全格式兼容框架

- IBM Granite 4.0 —— 与 vLLM、llama.cpp、MLX 一同被 IBM 博客重点提及

- Google EmbeddingGemma(NPU 推理)——获 Google 官方致谢

- Gemma-3n 多模态 —— 全球首个完整视觉多模态推理实现

- 硬件生态扩展:

- Intel NPU:支持 DeepSeek-r1-distill-Qwen-1.5B、Llama3.2-3B

- Apple Neural Engine:实现 Parakeet v3 实时语音识别;支持 Granite-4.0、Qwen3、Gemma3、Parakeetv3

- AMD NPU:成功运行 SDXL-turbo 图像生成

- 开发体验提升:

- 发布 Linux SDK(含 NPU/GPU/CPU 支持)

- 上线 Android SDK 与 Python SDK(支持 NPU/GPU/CPU),提供完整文档与 Demo

为什么选择 NexaSDK?

- 不只是封装,而是重构:NexaML 从底层构建,避免了对 llama.cpp 或 MLX 的路径依赖,实现真正的硬件-模型协同优化。

- 面向未来模型:通过自研格式 .nexa 与灵活架构,确保新模型发布当天即可本地运行。

- 端到端控制:开发者可精细控制推理流程、内存分配、量化策略与硬件调度,适用于高可靠场景(如车载、医疗、工业)。

- 开箱即用:提供 OpenAI 兼容 API、Function Calling、多语言 SDK,降低集成成本。